- Digitrode

- цифровая электроника вычислительная техника встраиваемые системы

- Motion capture в домашних условиях на основе ESP8266 и MPU6050

- Домашний Motion Capture

- Как начать работать с Motion Capture

- Что это такое?

- Как это работает?

- Во сколько всё это обходится?

- Каковы противоположные доводы?

- Хотите попробовать?

Digitrode

цифровая электроника вычислительная техника встраиваемые системы

Motion capture в домашних условиях на основе ESP8266 и MPU6050

Технология захвата движения (motion capture) все чаще используется в анимации, кинематографе и робототехнике. Профессиональные системы захвата движения, которые используются, например, в Голливуде, достаточно дорогие и непросты в эксплуатации. Но благодаря развитию и упрощению технологий систему захвата движения можно сделать своими руками. При этом она будет дешевой, поскольку она основана на популярном недорогом WiFi модуле ESP8266 и датчике MPU6050, включающем в себя акселерометр и гироскоп.

Проект Bewegungsfelder позволяет самостоятельно создать такую систему захвата движения. Она состоит из нескольких автономных инерциальных модулей, в состав которых входит датчик MPU6050 для регистрации движений, модуль ESP8266 для передачи данных и аккумулятор для питания этого автономного узла. Модуль ESP8266 считывает информацию с инерциального датчика MPU6050 с помощью интерфейса I2C. Данные, полученные от узлов, отправляются по беспроводному каналу на центральный сервер захвата движения. Приложение на сервере преобразует входные данные в скелетную анимацию, они визуализируются в режиме реального времени, а также сохраняются в памяти для дальнейшего использования. Поскольку датчиковые узлы являются полностью автономными, их можно с легкостью применять в отношении практически любой скелетной топологии, то есть их можно надеть на человека, кошку, робота или другой объект, движение которого нужно зарегистрировать.

Каждый датчик передает кватернион, содержащий информацию о текущей ориентации узла, а также необработанные данные об ускорении и угловой скорости. Протокол связи достаточно простой, и его легко реализовать на других микросхемах (в том числе на смартфонах).

В серверное приложение проекта Bewegungsfelder уже включена поддержка определения типов скелета, а также имеется функция импорта/экспорта файлов BVH для использования полученных данных в популярных 3D редакторах, таких как Maya или Blender.

Программная часть проекта выпущена с открытым исходным кодом и распространяется по лицензии MIT License. Прошивка для модуля ESP8266 и код для серверного приложения находятся в открытом доступе, и их можно скачать с репозитория GitHub.

С помощью этого проекта можно собрать действительно дешевую систему захвата движения, поскольку благодаря дешевым компонентам цена одного инерциального узла не превышает $5.

Источник

Домашний Motion Capture

Всем привет, хотелось бы создать домашний Motion Capture, ну или не совсем домшний, подскажите, как лучше сделать, купить несколько камер, или лучше просто купить kinect для xbox и с помощью него сделать. Есть довольно большой спортивный зал в нашем распоряжении, с постеленными матами, может там как-то обустроиться, хотелось бы более менее качественный Motion Capture, чтобы какие-то бойцовские анимации создавать ну и в принципе походка, бег, прыжки, итд.

Желательно чтобы не выходило за пределы 100 тысяч рублей решение.

http://ipisoft.com/

или аналоги

Это если совсем бюджетно и не очень качественно. Если нужна точность выше то онли маркерные технологии. Но там будет достаточно сложно, достаточно заморочено и сомневаюсь что в 100к реально будет уложиться.

Тоже интересна такая тема. Подписываюсь.

Вижу пока три варианта:

1. Светодиоды с батарейками накрепить на одежду. Отслеживать очень качественными камерами и хитрыми алгоритмами слежения. Недостатки: может случиться перекрытие светодиода для всех камер, должно вылечиться интерполяцией; нужно склеивать куски треков и назначать их костям после каждой съёмки.

2. Ультразвук. Микрофоны либо излучатели с микроконтроллерами на батарейках в качестве датчиков. Опорные микрофоны/излучатели в фиксированных местах комнаты. Получаем расстояния через задержку в скорости звука. Недостатки: сложность датчика; нужна обратная передача данных.

3. Магнитные поля. Датчик содержит МК, катушку и усилитель. В фиксированных местах комнаты передающие катушки. Расстояния считаются по угасанию интенсивности переменного магнитного поля. Недостатки: трудно сказать, возможно ли решить уравнение позиции датчика имея одну катушку в нём; придётся снять с себя металлические предметы и убрать таковые из комнаты; скорее всего будет очень много помех; нужна обратная передача данных.

Используй систему технического зрения

и одежду контрастных цветов, чтобы

распознавать ее было проще.

Из затрат — вебкамера, комп, одежда

Тыщ 20 уйдет на это дело.

Акселерометры навешай и интегрируй, вот тебе и примитивный моушн кэпчэ

Or1s

> http://ipisoft.com/

+ 2 kinect for windows — по моему для начала самое оно, ну постробработка конечно, чистить все равно придется особенно ноги (на 1 кинекте часто уплывают)

Int64

> Желательно чтобы не выходило за пределы 100 тысяч рублей решение.

Дай мне двадцатку. Не хватает на помещение. Задолбало комп на дачу возить. Ждать хорошей погоды, копать столбы и заряжать шуруповёрт.

А если по серьёзному надо 120 рублей на 4 камеры Canon eos 600d. Хотя можно найти без портретного объектива на несколько рублей дешевле. 60 fps 1024×720 это очень нормально так. Можно убивать мамонта в прыжке с разбегу и с разворота.

А забыл. Пульт надо для одновременного включения записи.

хм.. ну допустим я куплю 4 камеры Canon eos 600d, а там же еще нужно костюм склепать, каким он примерно должен быть? просто светодиоды наклеить, но как правильно их расположить на костюме, получается, там где сустав, должен быть светодиод? а светодиоды тогда с двух сторон лепить, или только с передней стороны?

captain NOVA потёр свои видосики и фоточки, жаль. Я свою почту тоже почистил, а в теме про рукоблудство он только себя демонстрирует.

Int64

> подскажите, как лучше сделать

Kinect2 купить.

Ребятки да всё упирается только в камеры. Нужны камеры 60 fps минимум, но этого хватает вполне. Найдите дешёвые usb вебкамеры hd 60 fps и будет вам счастье. У меня счас 5 камер. Наконец расставил их под правильными углами. Времени не хватает. Ремонт дома делаю. От себя хочется сказать не верьте в безмаркерную технологию. Это некачественная анимация. Поворот конечностей там определяется трудно. Я уж не говорю про движение лопаток, кистей рук. Я не знаю что там в последнее время ipi soft пытается демонстрировать. Но я тут по своим наработкам узрел инерцию головы во время удара рукой в slow motion. Блин это очень круто.

captain NOVA

> о я тут по своим наработкам узрел инерцию головы во время удара рукой в slow

> motion.

Это интересно, тебя били по голове или ты кого-то? Просто чтоб возникла инерция нужен реальный момент, ведь так?

rusk

Голова дёргается в конце полёта руки. У меня масса руки нормальная. При торможении в воздухе рука тянет за собой плечо, дальше шея и голова в конце. Я же никого не бью. Имитирую)) Хотя для реалистичности надо в грушу бить.

Источник

Как начать работать с Motion Capture

Закройте глаза и вернитесь… вернитесь в прошлое. Представьте Джа Джа Бинкса и «Полярный экспресс», подверженных эффекту «зловещей долины». Я знаю, что воспоминания не из приятных, но новые технологии (и захват движений – motion capture или сокращённо mocap – в их числе) могут быть… несколько странными в свои ранние годы. Теперь же забудем об этом и продвинемся вперёд – во времена, когда технология стала набирать обороты – от Голлума из «Властелина колец» до «Аватара» и Халка из «Мстителей». И про игры не забудем: в The Last of Us проделана самая впечатляющая работа с mocap-анимацией, а Electronic Arts использует её ещё с Madden NFL 94. Но что же представляет из себя данный метод и как он работает? Способен ли motion capture заменить живых актёров или оставить 3D-аниматоров без работы? Для ответа на эти вопросы мы отправимся на 100 лет назад.

Что это такое?

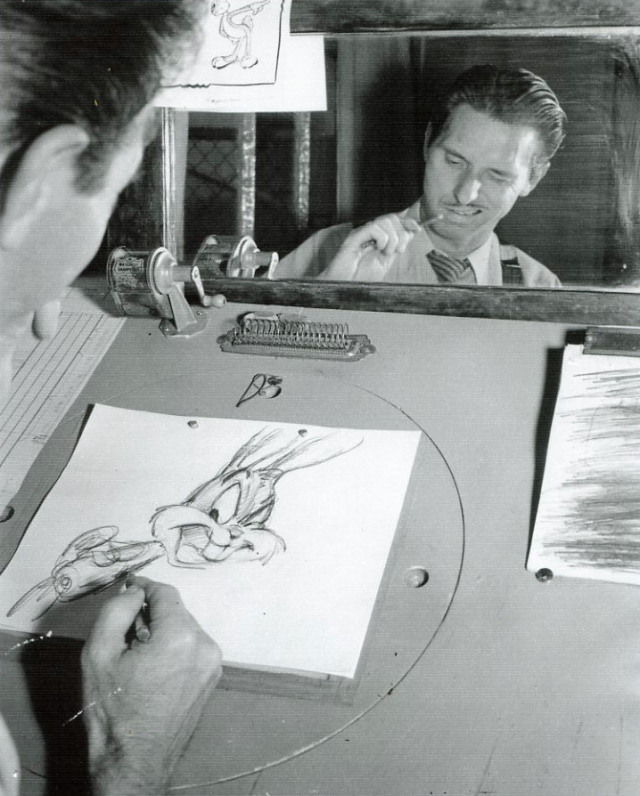

Вы, вероятно, представляете себе motion capture как актёров, скачущих в обтягивающей одежде с прикрепленными теннисными шариками. Но что же всё это значит? Проще говоря: авторы фильма или игры переносят все движения тела (и лица) актёра на анимированного персонажа. Участие компьютера в процессе по большому счёту и не требуется. В 1914 аниматор Макс Фляйшер (Max Fleischer) изобрёл «ротоскопию» – метод создания мультфильмов с помощью покадрового отслеживания действий актёров. Первым мультфильмом с ротоскопией в 1937 стала диснеевская «Белоснежка и семь гномов».

Даже при том, что аниматоры рисуют все движения персонажей от руки, они сравнивают картинку с игрой актёров на плёнке или даже глядя на себя в зеркало.

Ручное создание цифровой анимации называется анимацией по ключевым кадрам – при этом заполняются недостающие движения между «ключевыми» позами персонажа.

Для автоматизации процесса аниматоры обратились к motion capture. Исследователи биокинетики, например, Том Калверт (Tom Calvert) из Университета Саймона Фрейзера, открыли новые возможности с применением специальных костюмов. Одна компания создала устройство для захвата движений лиц и тела «Waldo» (на картинке выше), использующееся для управления аватаром нинтендовского Марио, общающимся с публикой на выставках. Между тем, Массачусетский технологический институт разработал свою «графическую марионетку» на основе LED – одну из первых технологий оптического отслеживания движений. Одним из первых её применений стал ужасный видеоклип Dozo от фирмы-первопроходчика Kleiser-Walczak (на видео ниже).

Поначалу захват движений был исключительно студийным процессом и актёры работали в пустой комнате, окружённой специальными камерами и лампами. «Аватар» явил нам «performance capture» («захват актёрской игры»), при котором совместно работали несколько актёров и захватывались выражения их лиц и движения губ. В играх наподобие L.A. Noire степень реализма также значительно повышается за счёт параллельного захвата движений лица и всего тела.

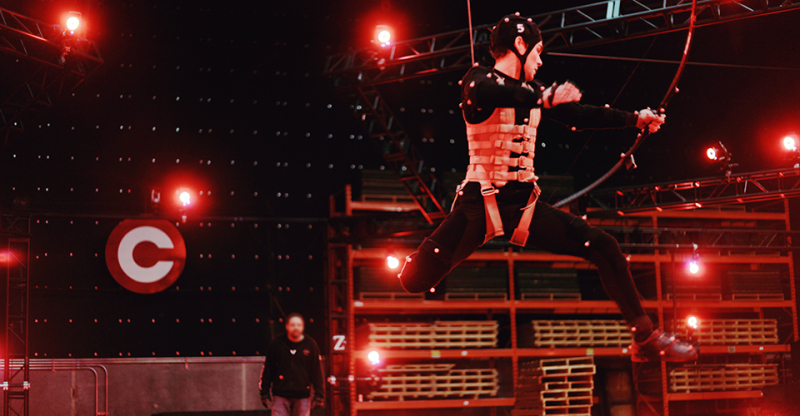

А создатели «Властелина колец» в своё время вынесли motion capture за пределы студии, что позволило Энди Серкису (Andy Serkis) взаимодействовать с другими актёрами в роли Голлума. В наши дни захват движений (в том числе и лица) прямо на съёмочной площадке стал нормой в производстве художественных фильмов с оцифрованными персонажами, как это видно ниже на примере съёмок картины «Планета обезьян: Революция» (да, тут у нас снова Серкис – он довольно популярен).

Как это работает?

Motion capture передаёт движения актёра персонажу, созданному на компьютере. Системы, которые для их отслеживания используют камеры (с маркерами или же без них), условно называют «оптическими», а замеряющие инерцию или механические движения – «не оптическими». В качестве примера вторых можно привести костюм захвата инерции XSens MVN, в котором работал Сет Роган (Seth Rogan) в роли инопланетянина Пола. Позже появились и другие системы, такие как оптический отслеживатель пальцев Leap Motion и браслет MYO, распознающий мышечную активность запястья и всей руки. Project Tango от Google используется преимущественно для построения виртуальных трёхмерных пространств, но благодаря Kinect-подобному сенсору обладает потенциалом и для захвата движений.

Оптические системы замеряют положение позиционных маркеров или отличительных элементов и на основании полученных данных создают приблизительную трёхмерную модель движений актёра. Активные системы используют горящие или мерцающие лампочки, а пассивные работают с инертными объектами, вроде белых шариков или просто точек, нанесённых краской (так часто делают при захвате движений лица). В безмаркерных системах используются алгоритмы распознавания, которые отслеживают положение каких-либо отличительных элементов – например, одежда актёра или его нос. Захваченные движения переносятся на виртуальный «скелет» анимированного персонажа такими программами, как MotionBuilder от Autodesk. Что в результате? Компьютерные персонажи с движениями живых актёров.

Сложно предугадать, как живые движения будут выглядеть на виртуальном персонаже, так что нередко используется придуманная Джеймсом Кэмероном (James Cameron) для «Аватара» так называемая «виртуальная кинематография». По сути, она в реальном времени отображает движения актёра на его персонаже – в виртуальной среде – так что режиссёр может сразу наблюдать сырую версию «актёрской игры». Такой процесс требует интенсивных вычислений, но в наши дни процессоры и видеокарты уже достаточно мощные, чтобы справиться с ними. Приведённый ниже ролик от Weta Digital наглядно демонстрирует процесс на примере фильма «Хоббит: Пустошь Смауга».

Во сколько всё это обходится?

Всё, что связано с 3D-анимацией, дешёвым не назовёшь, и захват движений не исключение. Но при этом все цифровые технологии со временем становятся дешевле. Если рассматривать самые простые варианты, то для дома мы с вами можем позволить себе безмаркерную систему отслеживания – будь то Kinect или iPi Motion Capture – приблизительно за $295. На противоположном краю ценового диапазона можно обнаружить новую студию EA, Capture Lab (на фото ниже), покрывающую 1600 квадратных метров и оснащённую новейшим программным обеспечением Vicon Blade и 132 камерами Vicon. Мы не знаем, сколько именно это стоит, но двухкамерная система Vicon вместе с одной лицензией на ПО обходится в $12500 (держите в уме, что вам ещё понадобится софт вроде MotionBuilder для переноса захваченных данных на персонажа – а это ещё плюс $4200 за копию для каждого сотрудника). Несмотря на такие цифры, захват движений обходится примерно в четверть или в половину затрат, необходимых на анимацию по ключевым кадрам, а результат выходит более реалистичным.

Каковы противоположные доводы?

Отношение к реалистичности? Хех. Многие люди попросту ненавидят motion capture. Если вы – один из них, то оцифрованные персонажи не заменят вам классический стиль Nintendo или мультфильмы с ручной рисовкой старой школы – «Унесённые призраками» или «Looney Tunes». Светила анимации в лице Чака Джонса (Chuck Jones) и Хаяо Миядзаки (Hayao Miyazaki) вкладывают свою душу – и множество часов ручного анимирования – в создание запоминающихся персонажей. Хотя исполнение Серкиса и послужило прочной основой для шизофреничного Голлума, персонаж ещё долго дорабатывался аниматорами. Впрочем, Серкис забрал все лавры себе, заявив, что аниматоры просто накладывают «цифровой макияж».

Для продюсеров motion capture может выглядеть заманчивым способом сэкономить. Но захваченные данные не всегда можно сразу же пускать в ход – в большинстве случаев им предстоит пройти значительную (и сложную) обработку. К тому же итоговый результат может не совпадать с изначальным представлением продюсера. Анимация близка к натуральной, но всё же не полностью реалистичная, так что есть риск оттолкнуть зрителя «зловещей долиной».

Но всё же, для технологии захвата движений найдётся применение. Современные игры требуют продвинутой анимации для повышения степени реализма. Такие персонажи, как Голлум, Дэйви Джонс и Смауг уже практически стали классикой, отчасти благодаря актёрам, вдохнувшим в них жизнь. В этом и суть захвата движений, не так ли? Лучший способ создать запоминающегося компьютерного персонажа – запоминающаяся актёрская игра талантливых людей.

Хотите попробовать?

Подробнее про типы систем захвата движений и оборудование можно прочитать в переводе книги «Choosing a real-time performance capture system». Имея в запасе пару тысяч долларов стоит присмотреться к iClone Motion LIVE, который работает с Leap Motion, Faceware и костюмами захвата движений Perception Neuron, OptiTrack, Xsens.

Желаете попробовать себя в 3D-анимации/motion capture в домашних условиях? Есть масса бесплатных возможностей! Autodesk предлагает бесплатно и без ограничений использовать большинство своих продуктов в течение 30 дней (студентам – 3 года) – начать стоит с MotionBuilder и Maya или 3DS Max. Также у Autodesk есть много обучающих руководств и советов в разделе Area. Если у вас под рукой найдётся пара камер Sony PS Eye или Kinect, можете побаловаться с бесплатной пробной версией iPi Soft. Если вы хотите пропустить процесс захвата и поэкспериментировать с уже готовыми файлами движений, у Университета Карнеги-Меллон их полным-полно здесь. Если вас просто заинтересовала данная тема, можете поискать информацию на сайтах, посвящённых цифровым эффектам и игровой тематике.

Источник